| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |

Tags

- edwith

- JavaScript

- Unity

- 프로그래머스

- 자바

- 딥러닝

- MySQL

- 쿠킹덤

- Java

- dart

- 홀리데이익스프레스

- Eclipse

- MERN

- HTML

- 웹개발

- SQL

- 쿠키런킹덤

- 티스토리챌린지

- 이클립스

- 크리스마스

- Spring

- 개발자

- 유니티

- 쿠키런킹덤크리스마스

- oracle

- react

- 쿠키런킹덤공략

- 오블완

- 자바스크립트

- programmers

Archives

- Today

- Total

Dev study and Repost

[딥러닝] 4-8 활성화 함수의 미분 본문

반응형

이전포스팅:https://devlunch4.tistory.com/105

[딥러닝] 4-7 왜 비선형 활성화 함수를 써야할까요?

이전포스팅; https://devlunch4.tistory.com/104 [딥러닝] 4-6 활성화 함수 이전 포스팅: https://devlunch4.tistory.com/102 [딥러닝] 4-5 벡터화 구현에 대한 설명 이전포스팅; https://devlunch4.tistory.com/1..

devlunch4.tistory.com

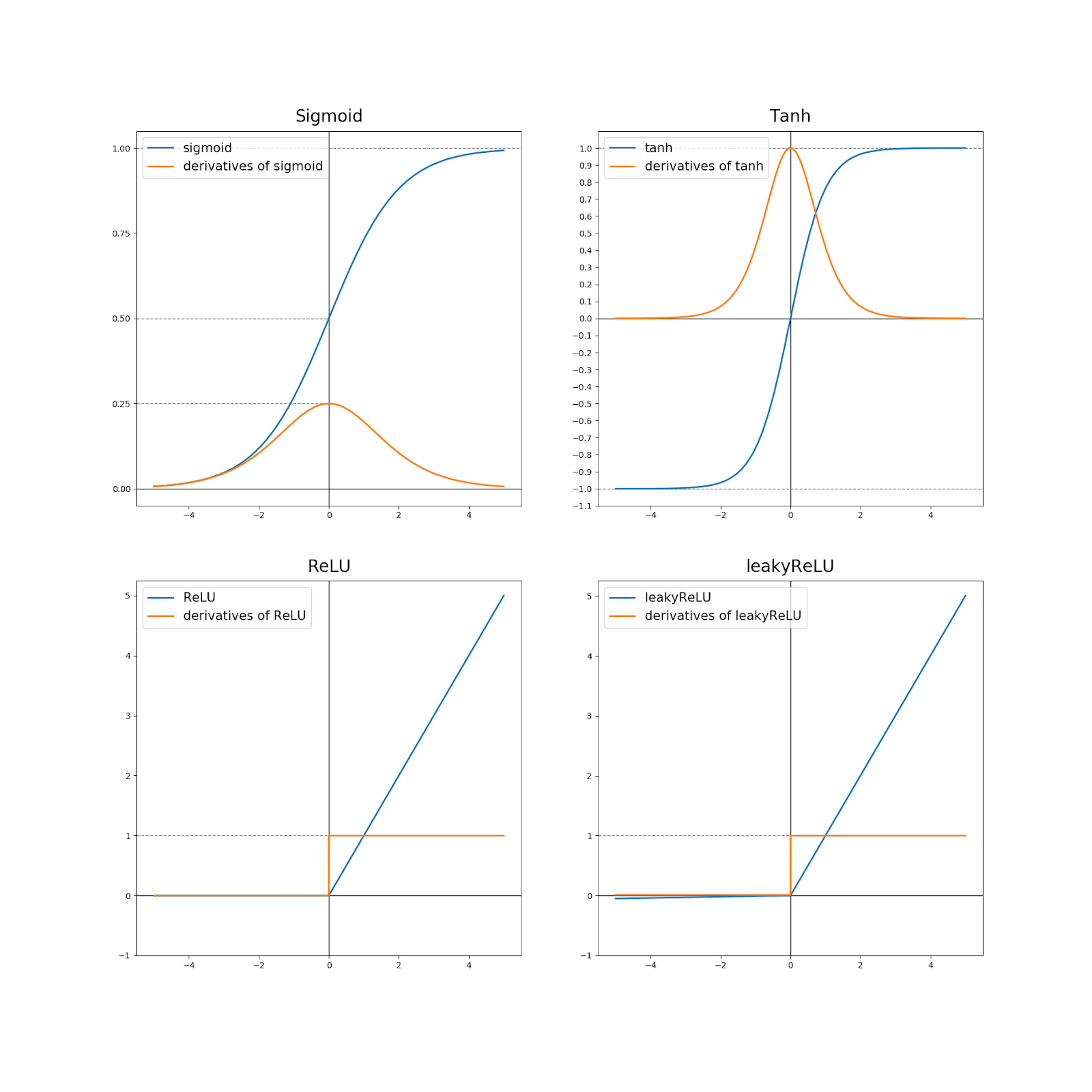

4-8 활성화 함수의 미분

학습목표; 활성화 함수를 미분할 수 있다.

핵심키워드; 미분(Derivatives)

학습내용;

- 시그모이드

g(z)=1/(1+e^−z1)

g′(z)=(d/dz)*g(z)=g(z)(1−g(z))

- Tanh

g(z)=(e^z-^e-z)/(e^z+e^-z)

g′(z)=1−(g(z))^2

- ReLU

g(z)=max(0,z)

g′(z)=0 (z < 0인 경우)

g′(z)=1 (z >= 0인 경우)

- Leaky ReLU

g(z)=max(0.01z,z)

g′(z)=0.01 (z < 0인 경우)

g′(z)=1 (z >= 0인 경우)

- 영상시작

- >

- 신경망의 역방향 전파를 구현하려면 활성화 함수의 도함수를 구해야한다.

- 활성화 함수와 그 함수의 기울기를 어떻게 구하는가?

- 요약하자면 a가 g(z)인 tanh(z)일 때 도함수인 g'(z)는 1 - a²가 됩니다

- >

- 끝.

반응형

'IT INFO' 카테고리의 다른 글

| [딥러닝] 4-10 역전파에 대한 이해 (0) | 2021.08.15 |

|---|---|

| [딥러닝] 4-9 신경망 네트워크와 경사 하강법 (0) | 2021.08.15 |

| [딥러닝] 4-7 왜 비선형 활성화 함수를 써야할까요? (0) | 2021.08.15 |

| [딥러닝] 4-6 활성화 함수 (0) | 2021.08.15 |

| [JAVA] 람다, 스트림(1) (0) | 2021.08.13 |

Comments